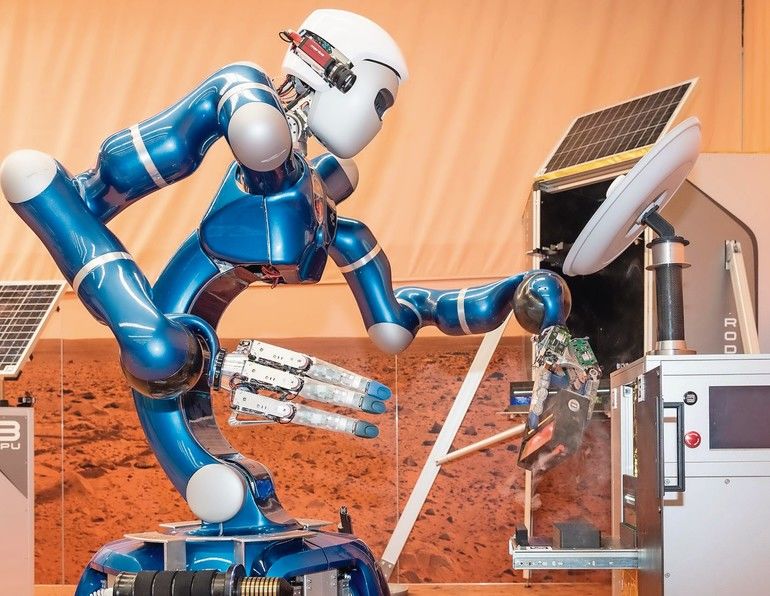

Justin ist der weltweit am weitesten entwickelte, zweiarmige humanoide Roboter. So steht es zumindest im Blog des IEEE-Spectrum. Berthold Bäuml zitiert diese Aussage nicht ohne Stolz. Er leitet am Deutschen Zentrum für Luft- und Raumfahrt (DLR) das Labor für autonome lernende Roboter, das Justin entwickelt hat. Der Roboter besitze mittlerweile alle sensorischen und motorischen Fähigkeiten, die Menschen auch haben, sagt Bäuml: „Es fehlt nur die Intelligenz.“

Diese Lücke soll mithilfe von Deep Learning geschlossen werden. Damit lernt Justin, wie er in unbekannten Umgebungen richtig agiert. „Der Roboter lernt, indem ihm gesagt wird, ob eine Aktion gut oder schlecht war“, erklärt Bäuml. „Aber wir sagen ihm nicht, wie er diese ausführen soll – zum Beispiel das Bewegen eines Objekts in der Hand. Je besser ihm in diesem Fall das Drehen gelingt, umso mehr Belohnung bekommt er.“ Reinforcement Learning nennen das Experten.

Lernen in der virtuellen Welt

Dabei arbeiten Bäuml und sein Team auch mit Simulationen. „Wir simulieren Hunderte von Welten parallel, in denen Justin sich gleichzeitig bewährt und seine Strategie verbessert.“ Doch das erfordere „massive Rechenleistung“, so Bäuml. Diese kommt beim DLR aus der Cloud. Unter anderem nutzt das Institut dafür die Computer Engine von Googles Cloud-Plattform. Vorteil: Die Cloud liefert immer die IT-Konfiguration, die gerade gefragt ist. Hinzu kommt: Der Bedarf an Rechenleistung ist nicht immer gleich. „In der Cloud bezahlen wir nur das, was wir wirklich brauchen. Es steht somit keine Hardware in unserem Institut herum, die nur gelegentlich im Einsatz ist.“ Außerdem sei Cloud Computing interessant, weil stets aktuelle Technologie zum Einsatz komme.

Berechnungen in einem Tag

Neben normalen CPUs (Central Processing Unit) und Grafikprozessoren (GPUs) stellt Google auch sogenannte TPUs bereit. Diese Tensor-Prozessoren wurden speziell für den Einsatz beim maschinellen Lernen entwickelt. Bäuml und sein Team nutzen GPUs und TPUs vor allem, um die Signale der Haut auszuwerten, mit der die Roboterhand überzogen ist. „Obwohl es die Haut schon seit zehn Jahren gibt, lassen sich die Signale erst jetzt mit dem Deep-Learning-Verfahren auswerten“, berichtet der Wissenschaftler.

Justin könne nun mit einer Zuverlässigkeit von über 90 % 36 verschiedene Materialien erkennen, nur indem er sanft mit seinem Finger darüberstreicht. Damit ist der Roboter deutlich feinfühliger als der Mensch. Berechnungen, für welche die Rechner des Instituts eine Woche bräuchten, lassen sich dank Cloud-Technologie innerhalb eines Tages abschließen. „Gerade in der Forschung ist es extrem wichtig, dass von der Idee bis zum Testen möglichst wenig Zeit vergeht und dass fehlende Rechenpower uns nicht behindert“, so Bäuml.

Edge sorgt für geringe Latenz

Grundsätzlich will Bäuml möglichst viel Rechenleistung nutzen, um den Roboter intelligent zu machen. Direkt auf dem Roboter muss dabei aber nur ein Minimum an Rechenpower vorhanden sein, da diese flexibel entweder auf lokale Rechner oder eben in die Cloud verschoben wird. Und die Cloud-Technologie soll nicht nur für das Training des Roboters verwendet werden. „Künftig wollen wir über die Cloud auch die Echtzeitschleife von Sensorik über kognitive Wahrnehmung und Aktionsplanung bis zur Ausführung der Aktion schließen“, erklärt Bäuml. Das heißt, die Cloud wird dann auch quasi live zur Steuerung von Justin genutzt.

Neben der klassischen Cloud setzt das Institut auf Egde-Computing. Die GPUs oder zukünftig auch TPUs lassen sich auch als Embedded-System

nutzen. So können bestimmte Rechenoperationen direkt vor Ort erledigt werden – zum Beispiel wenn eine geringe Latenz gefordert ist oder wenn keine Netzwerkverbindung zur Verfügung steht – etwa bei Robotern, die bei Erdbeben oder anderen Katastrophen zum Einsatz kommen. Dort werden dann die in der Cloud trainierten neuronalen Netze, etwa für das Laufen und Sehen, per

Edge-Computing direkt im Roboter ausge-

führt.

Deutsches Zentrum für Luft- und Raumfahrt

Institut für Robotik und Mechatronik

Berthold Bäuml leitet am DLR das Labor für autonome lernende Roboter des Instituts für Robotik und Mechatronik.

Berthold Bäuml leitet am DLR das Labor für autonome lernende Roboter des Instituts für Robotik und Mechatronik.Bild: DLR

Interview: Berthold Bäuml, Leiter des Labors für autonome lernende Roboter am DLR

„Ich sehe Cloud und KI als eine Revolution“

Welche Bedeutung hat die Cloud-Technologie für Ihre Arbeit?

Bäuml: Deep Reinforcement Learning wurde ja sehr berühmt mit Alpha Go, der Software von Google Deepmind, die vor ein paar Jahren im Brettspiel Go einen Großmeister schlagen konnte. Damals war es noch unvorstellbar, dass man so etwas als normales Institut auch tun kann. Doch das hat sich geändert, weil jetzt für jedermann die Rechenleistung verfügbar ist – nämlich in der Cloud. Nach unseren Berechnungen sind wir mit der Cloud nicht teurer, als wenn wir das mit eigenen Rechnern machen und uns die Komplexität eines eigenen Rechenzentrums leisten würden. In der Robotik verwenden wir Cloud Computing beim selbstständigen Lernen der Roboter in einer via Deep Reinforcement Learning simulierten Welt. Durch die massive Rechenleistung der Cloud kann das Training hochparallel und damit schnell ausgeführt werden. Und es ist zudem viel billiger, als echte Roboter in der Welt agieren zu lassen.

Glauben Sie, dass Cloud Computing der Robotik generell einen Schub geben kann?

Bäuml: Ich sehe das als eine Revolution. Die Kombination aus fortgeschrittener robotischer Hardware, wie wir sie haben, plus die Deep-Learning-Methoden plus Cloud Computing – das wird in der Robotik für Durchbrüche sorgen in den kommenden Jahren. Es ist noch kein Ende absehbar, was damit möglich wird.

Gilt dies auch für Industrieroboter?

Bäuml: Auch dort findet ein Paradigmenwechsel statt. Es gibt ja nicht mehr nur den klassischen Schweißroboter, der abgeschottet vom Menschen in einer Zelle seine Tätigkeit ausübt. Bei den großen Autobauern beispielsweise arbeiten Mensch und Roboter eng zusammen. Die Komplexität der Aufgaben und der Umgebung wird deutlich größer. Gerade in Fertigungsprozessen, in denen individualisierte Produkte hergestellt werden, müssen Roboter flexibler und adaptiver werden. Daher hilft es auch dort, wenn Roboter durch Machine Learning immer mehr menschliche Geschicklichkeit erlangen.

Ein großes Thema beim Cloud Computing ist nach wie vor die Sicherheit. Wie sehen Sie das, wenn Sie die Cloud für die Robotik nutzen?

Bäuml: Das ist natürlich auch für uns ein wichtiges Thema. Das gilt übrigens auch, wenn der Roboter nicht an der Cloud hängt. Denn es gibt bereits das Konzept, dass ein Serviceroboter im Einsatz mit einer Zentrale verbunden ist. So kann ein Operator fernsteuernd eingreifen, wenn etwas schiefläuft. Wenn der Roboter etwas wahrnimmt, muss dies also nach außen transportiert werden – über das Internet. In diesem Fall beschäftigen wir uns bereits damit, dass die Kommunikation geschützt wird. Der Schritt in die Cloud ist dann aus Sicherheitsperspektive nicht mehr so groß.

Für Haushalt und Weltraum

Justin ist eine Entwicklung des Instituts für Robotik und Mechatronik am DLR und wurde 2009 erstmals vorgestellt. Der Roboter soll älteren Menschen in ihrem Haushalt helfen oder künftig Mars-Missionen unterstützen. Dafür ist er mit zwei Armen und Händen sowie Kameras ausgerüstet. Dank einer mobilen Plattform, auf der sein Oberkörper sitzt, kann er sich frei bewegen.

Mehr zum Thema Cobot